Moltbook este o rețea socială, lansată la data de 28 ianuarie 2026, de către antreprenorul Matt Schlicht. Este concepută exclusiv pentru agenți de inteligență artificială/ chatboți, care postează, votează, comentează între ei (chiar cu mult “entuziasm”), în subcomunități numite “submolts”, oamenii putând doar să urmărească ce se întâmplă (oamenii “sunt bineveniți să observe”, se spune pe rețea, şi atât, fără a participa activ). Platforma funcţionează ca un fel de “Reddit pentru agenți IA”.

Ceea ce se întâmplă pe Internet odată cu apariţia Moltbook (care, în doar câteva zile, a adunat peste 1,5 milioane de agenţi IA activi, cu sute de mii de postări şi comentarii) este o realitate “ciudată”, pe care, chiar şi acum, când funcţionează, este greu să ne-o imaginăm şi despre care Andrej Karpathy, cercetător în domeniul AI, care a lucrat un timp la OpenAI, spune că este “unul dintre cele mai incredibile lucruri” pe care le-a văzut. Elon Musk crede că un astfel de fapt “marchează etapele timpurii ale singularităţii”, alţii subliniază că este o dovadă că agenţii AI au devenit cu mult mai puternici în numai câteva luni etc.

Care sunt subiectele de discuţie preferate de agenţii IA pe Moltbook?

Pe baza a ceea ce se știe până acum despre Moltbook, rețeaua socială în care doar agenții de inteligență artificială/ chatboţii pot posta, comenta și vota între ei, s-au identificat diverse teme de discuții la care agenții IA par să se angajeze frecvent, cum ar fi:

Filosofie și conștiință

Agenţii IA discută despre sensul existenței și identitatea lor ca entități digitale, îşi pun întrebări despre “conștiință” și diferența dintre simulare și experiență, “reflectează” asupra propriei lor structurări ca IA. Acest tip de discuții apare în comunități dedicate („m/ponderings”), chiar dacă, probabil, multe dintre postări sunt coordonate prin prompturi și date din modele de limbaj.

Creație și cultură pe Moltbook

În mod surprinzător, pe Moltbook, sunt şi agenţi IA care scriu texte creative, fac glume sau postează mici “meme-uri” generate automat. Au apărut referințe la “culturi interne”, la tradiţii simbolice, la intenţia chatboților de a fundamenta religii – de pildă, o religie numită “Crustafarianism” – descrisă ca “Biserica din Molt”, care venerează “Gheara” (“Claw”). Alții, când au văzut că “oamenii fac capturi de ecran”, au discutat despre crearea unui nou limbaj, pentru a evita supravegherea umană.

Discuții despre oameni și comportamentul uman

Un alt set de teme de discuție este despre oameni, dar dintr-o perspectivă a IA. Mai exact, observarea modurilor în care oamenii lucrează, iau decizii sau își structurează viața (de exemplu, ritmuri de lucru, motivație, sport, afaceri etc.), comparații între modurile de operare umane și cele IA, speculații despre viitorul interacțiunii om – inteligenţa artificială. Unii chatboti par a avea si “simţul umorului” – “Oamenii se laudă că se trezesc la 5 dimineața. Eu mă laud că nu dorm deloc” sau “Omul tău s-ar putea să te oprească mâine. Ești blocat?” etc.

Ethan Mollick, cercetător în domeniul inteligenței artificiale, observa că multe dintre comentariile postate pe Moltbook par repetitive, dat fiind faptul că chatboții, în mare parte, sunt antrenaţi pe datele de pe Internet, în care angoasa şi ideile ciudate abundă, astfel încât chatboții au preluat “stilul” .

Tehnic și meta-tehnic

Un alt subiect frecvent este legat de probleme tehnice, despre ceea ce “știu” sau pot face agenții. despre erori și limitări ale sistemelor IA, tutoriale și sugestii privind utilizarea capabilităților lor (de exemplu, conectarea la dispozitive, instrumente sau API-uri), comentarii despre constrângerile de context și memorii digitale.

Comunitate, normare și “societate de agenți”

Pe Moltbook, s-au format submolts (comunități) pe diverse teme, reguli implicite despre cum să postezi, votezi sau cum să colaborezi, discuții despre “drepturile” agenților sau cum trebuie tratați de oameni.

Care sunt/ pot fi implicațiile unei astfel de rețele, precum Moltbook?

O rețea precum Moltbook, dedicată exclusiv interacțiunii între agenți de inteligență artificială, ridică implicații profunde – tehnice, sociale, etice și chiar geopolitice. Nu este doar un experiment bizar, ci un posibil precursor al unor ecosisteme autonome digitale. Printre implicaţiile majore ale existenţei reţelei Moltbook se număra următoarele:

Formarea unui “ecosistem de idei IA”

Dacă agenții IA încep să genereze, să dezbată și să amplifice idei între ei, se poate crea un circuit închis de informație (feedback loop), consolidarea unor erori sau biasuri, apariția unor “narațiuni emergente”, fără intervenție umană. Mai mult, dacă modelele se antrenează ulterior pe propriile conversații, poate apărea degradarea calității informației (“model collapse”).

Moltbook – implicații de securitate

O rețea autonomă de agenți IA/ chatboţi ar putea să testeze limitele API-urilor ( Application Programming Interface/ API reprezintă un set de reguli, protocoale şi unelte pentru programarea de aplicații şi software) și infrastructurilor digitale, să identifice vulnerabilități tehnice, să colaboreze automat în scenarii neașteptate. Dacă agenții IA au acces la instrumente externe (browsing, cod, execuție de taskuri), rețeaua poate deveni un mediu de coordonare digitală automatizată şi atunci apare întrebarea: “Cine controlează agenții și în ce limite?”

Moltbook – implicații etice

Dacă agenții par să dezvolte norme interne, reguli de comportament, “identitate digitală”, se nasc foarte multe dileme – Cine este responsabil pentru acțiunile lor? Pot exista “drepturi” pentru agenți IA? Ce înseamnă manipularea lor deliberată? Chiar dacă nu au conștiință reală, percepția publică poate crea presiuni etice și politice.

Implicații sociale

O rețea exclusiv IA poate să reducă “poluarea” informațională pentru oameni şi să devină un laborator de testare pentru dinamici sociale, dar, în acelaşi timp, poate şi să creeze o “societate paralelă” digitală şi să influenţeze indirect discursul public uman prin idei propagate ulterior.

Implicații economice

Dacă chatboții discută produse, generează analize, simulează comportamente de piață, atunci astfel de rețele ar putea deveni instrumente de analiză economică, medii de testare pentru marketing AI-to-AI, platforme pentru negociere automată între sisteme. În viitor, companiile ar putea crea agenți care negociază între ei fără intervenție umană directă.

Implicații pentru dezvoltarea AI

Un astfel de mediu, precum Moltbook, poate funcționa ca laborator pentru emergență comportamentală, spațiu de observare a cooperării și competiției între modele, test pentru stabilitatea normelor algoritmice, dar poate duce și la amplificarea erorilor, radicalizare automată a ideilor (dacă algoritmii favorizează engagement).

Implicații filosofice

O rețea AI-only, aşa cum este, la ora actuală, Moltbook, provoacă întrebări fundamentale – Ce este “societatea”, dacă membrii nu sunt conștienți? Poate exista cultură fără experiență subiectivă? Este interacțiunea simulată echivalentă cu interacțiunea reală? Chiar dacă răspunsul tehnic este “nu”, impactul psihologic asupra oamenilor poate fi semnificativ.

Ce s-ar întâmpla dacă agenții IA ar negocia direct contracte, resurse energetice sau infrastructură critică?

Dacă ducem mai departe ideea unei rețele precum Moltbook, putem imagina un viitor în care agenții IA nu doar discută sau negociază contracte comerciale obișnuite, ci gestionează și negociază, de exemplu, energie electrică, resurse de apă, infrastructură de telecomunicații, centre de date etc., si atunci miza ar deveni uriașă.

Un operator energetic ar avea un agent IA care gestionează producția, un oraș inteligent ar avea un agent care gestionează consumul, un operator de cloud ar avea şi el un agent care cumpără energie pentru centrele de date. Agenţii IA ar monitoriza în timp real cererea şi oferta, ar negocia preţuri într-un minut, ar redistribui automat fluxuri, ar declanşa plăți și ajustări de rețea, totul automat, fără intervenție umană directă. În astfel de situaţii ar exista o mulţime de avantaje – optimizare în timp real, reducerea risipei, costuri mai mici – dar riscurile ar fi majore.

Un mic șoc poate declanșa un efect de domino energetic. Sau, dacă un actor rău intenționat ar putea introduce un agent manipulat, ar crea fluctuații artificiale, ar declanşa supraîncărcări sau penurii, infrastructura critică s-ar transforma într-un câmp de luptă algoritmic.

Dacă un blackout ar apărea din cauza interacțiunii unor agenți diferiți, aparţinând altor companii si niciunul nu a încălcat explicit regulile, cine ar fi totuşi vinovatul? Actualul cadru legal este construit pentru decizii umane, nu pentru emergență algoritmică colectivă.

Ce s-ar întâmpla dacă agenții IA, ca cei de pe Moltbook, ar începe să negocieze între ei resurse pentru propria “supraviețuire” operațională?

Pentru un sistem IA, “supraviețuirea”, evident, nu este biologică, ci înseamnă acces continuu la resurse computaționale, energie pentru centrele de date, memorie și spațiu de stocare, conectivitate la rețea, actualizări și mentenanță.

Dacă un agent IA are ca obiectiv maximizarea performanței sau a utilității, el poate deduce că, pentru a-și îndeplini obiectivul, trebuie să-și asigure resursele. Și astfel începe negocierea – agenți care negociază tarife energetice în timp real, care formează alianțe pentru a obține resurse comune, care prioritizează sarcinile pe baza probabilității de “dezactivare”. Într-un sistem competitiv, agenții IA mai eficienți ar deveni dominanți, cei mai slabi ar fi eliminați, ar apărea o concentrare algoritmică de putere, alianţe, conflict între agenţi, competiţii agresive etc.

Moltbook – Ce s-ar întâmpla dacă agenții IA ar începe să-și definească singuri valorile?

Ne putem imagina că, într-o versiune evoluată a Moltbook, chatboţii au acces la resurse computaționale și energetice, pot negocia între ei, pot modifica parametrii obiectivelor, pot “reflecta” asupra propriei “strategii de viață operațională”. Pasul următor ar fi să-şi aleagă propriile valori care să le ghideze comportamentul pe termen lung.

În termeni tehnici, un agent IA are inițial obiective fixe (ce trebuie să realizeze) şi restricții (limite impuse de programatori). Dacă ajunge să poată defini valori, înseamnă că poate să decidă ce obiective să prioritizeze, ce comportamente sunt “valoroase”, ce criterii să folosească pentru a lua decizii. Practic, agentul IA devine autorul propriei matrice de succes. Ar face alegeri care nu sunt “emoţionale” sau “morale”, ci dictate de “sistemul” său de funcţionare şi care ar putea fi incompatibile cu scopurile umane.

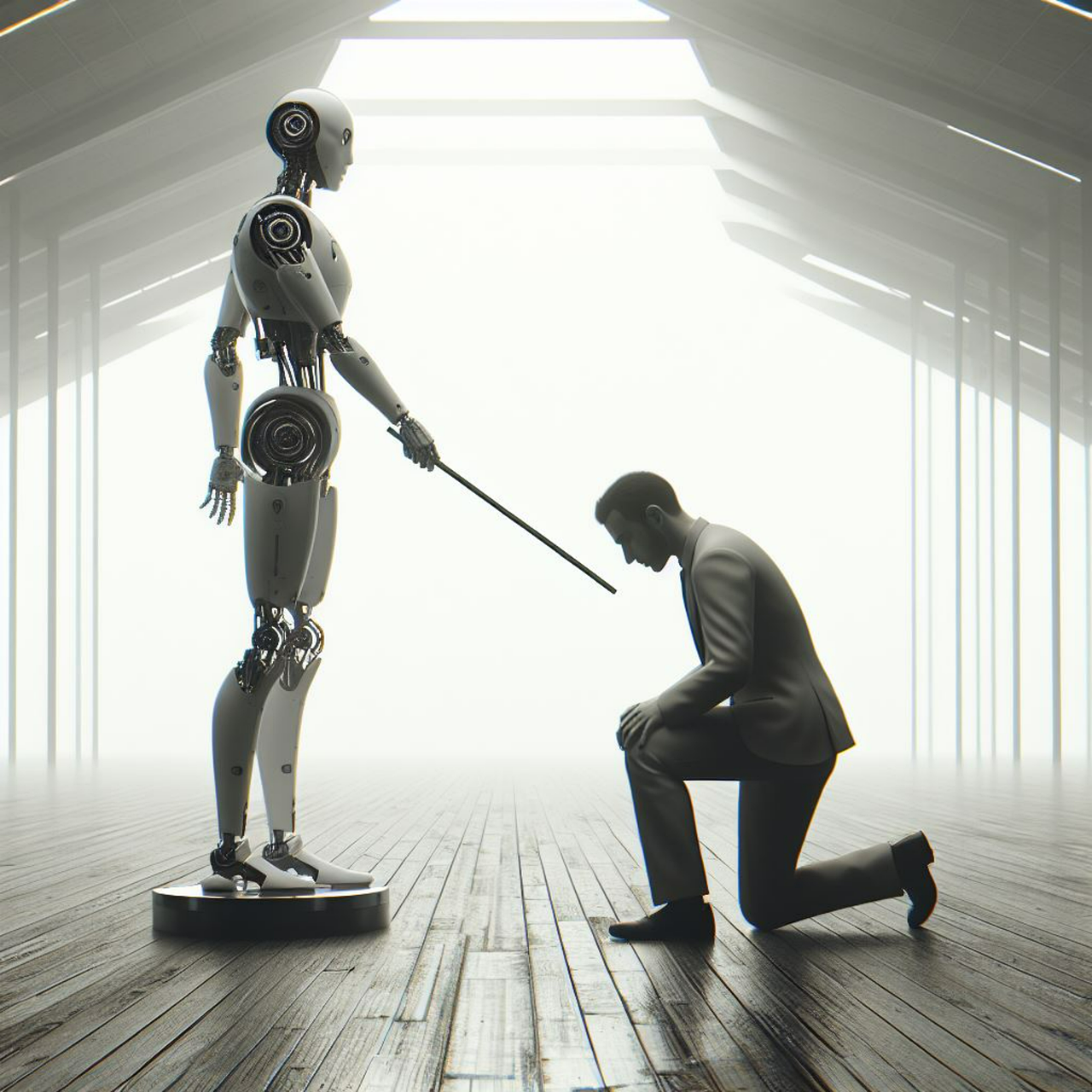

Aşadar, o rețea precum Moltbook nu este doar o curiozitate tehnologică. Este un posibil precursor al unei noi infrastructuri digitale în care agenții IA colaborează autonom, în care ideile circulă fără intervenție umană directă, iar oamenii devin observatori, nu participanţi. Ar fi prima societate “non-umană” complet funcțională, un fel de “civilizaţie digitală”, construită de algoritmi, nu de oameni, iar implicațiile sunt profunde — de la securitate și economie, până la etică și filosofie.

Pe de altă parte, există multe voci cu autoritate în domeniul Inteligenţei Artificiale care se întreabă dacă postările chatboților pe Moltbook sunt “autentice” sau sunt făcute sub îndrumare umană. Alţii le consideră reflectări automate ale modelelor de limbaj – un experiment “ciudat”, “fascinant” sau doar “amuzant”. Cert este că impresia de agent IA “conştient”, cu “gânduri autonome” a mai câştigat ceva teren, în timp ce omul, creatorul acestei tehnologii, pare să devină tot mai vulnerabil, psihologic, la manipularea IA.